摘要:针对近年来城市交通的拥挤现象,特别是驾驶员违章严重、交通事故频发等问题,介绍了在现代交通控制和管理系统中占有十分重要地位的传感器—视频车辆检测器。主要利用CCD摄像机与图像处理技术,完成了视频交通车辆信息检测器,给出了系统的软件和硬件构架,并详细分析了关键计算手段与方法。

关键词:交通信息;视频检测;目标识别;目标跟踪

0 引 言

智能交通系统是集计算机、信息、电子及通信等众多高新科技手段于一体的交通控制和管理系统,是21世纪交通的重要发展方向。它通过对道路交通车辆的信息进行实时检测,利用各种智能寻优算法及时确定出相应的控制策略,从而对交通流进行调节、警告和诱导。它的应用大大减少了道路交通违法、交通事故的发生,有效地提高了交通效率和安全性,从而使交通设施得以充分利用,实现交通运输的集约式发展。而智能交通系统中的交通车辆信息检测技术是实现动态智能交通控制的基础,在现代交通控制管理和道路规划中占有十分重要的地位。

早期的智能交通系统大量采用环形线圈车辆检测器,其检测精度高、成本低廉,但其工程安装难度大,施工时要破坏路面,所能够检测的交通信息种类少。随着计算机图像处理与机器视觉理论的日趋完善、计算机硬件技术地迅猛发展、高速处理芯片和高速大容量存储芯片的出现与普及,使得从图像序列中检测出运动信息、识别与跟踪运动目标成为计算机视觉领域中一个非常活跃的分支,从而使视频交通车辆检测技术得到了较快发展。利用该项技术开发的视频交通车辆信息检测器,其安装和维护简便、所采集的信息量大、信息种类多、检测区域宽,基本克服了上述环形线圈车辆检测器的不足,代表了未来交通信息检测领域的发展方向。

1 系统组成

1.1 硬件结构

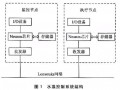

视频交通车辆信息检测器硬件结构如图1所示。它由工业CCD摄像机、PCI总线四路实时视频采集卡、单板工业控制机(带PCI总线接口)、DOM电子盘、I/O扩展卡和视频交通信息叠加模块构成。

关键词:交通信息;视频检测;目标识别;目标跟踪

0 引 言

智能交通系统是集计算机、信息、电子及通信等众多高新科技手段于一体的交通控制和管理系统,是21世纪交通的重要发展方向。它通过对道路交通车辆的信息进行实时检测,利用各种智能寻优算法及时确定出相应的控制策略,从而对交通流进行调节、警告和诱导。它的应用大大减少了道路交通违法、交通事故的发生,有效地提高了交通效率和安全性,从而使交通设施得以充分利用,实现交通运输的集约式发展。而智能交通系统中的交通车辆信息检测技术是实现动态智能交通控制的基础,在现代交通控制管理和道路规划中占有十分重要的地位。

早期的智能交通系统大量采用环形线圈车辆检测器,其检测精度高、成本低廉,但其工程安装难度大,施工时要破坏路面,所能够检测的交通信息种类少。随着计算机图像处理与机器视觉理论的日趋完善、计算机硬件技术地迅猛发展、高速处理芯片和高速大容量存储芯片的出现与普及,使得从图像序列中检测出运动信息、识别与跟踪运动目标成为计算机视觉领域中一个非常活跃的分支,从而使视频交通车辆检测技术得到了较快发展。利用该项技术开发的视频交通车辆信息检测器,其安装和维护简便、所采集的信息量大、信息种类多、检测区域宽,基本克服了上述环形线圈车辆检测器的不足,代表了未来交通信息检测领域的发展方向。

1 系统组成

1.1 硬件结构

视频交通车辆信息检测器硬件结构如图1所示。它由工业CCD摄像机、PCI总线四路实时视频采集卡、单板工业控制机(带PCI总线接口)、DOM电子盘、I/O扩展卡和视频交通信息叠加模块构成。

工业CCD摄像机的视频信号通过视频采集卡实时采集和数字化形成连续的数字图像序列。单板工业控制机经过对连续数字图像序列的预处理、特征提取,在图像序列中进行特征匹配,进而实现对目标物体的搜索,并从图像序列中获取目标动态信息,以达到识别和跟踪目标的目的。I/O扩展卡用于向其他设备(如,交通信号机、交通违章抓拍设备)实时传送车辆有无的触发信号。视频交通信息叠加模块用于对视频信号进行交通信息字符叠加,经视频交通信息叠加后的视频信号通过光纤传至交通指挥中心。

1.2 软件主要构架及数学模型

视频交通车辆信息检测器的软件主要构架包括:观察区域视频获取、观察区域背景估计、目标区域分割、目标区域特征描述、目标的确定及模式识别、目标位置的具体描述、目标特征空间跟踪、交通信息计算八部分。

设k(x,y,k)为第K帧序列图像[1],01[ ]为目标区域分割算子,02[ ]为目标识别特征提取算子,03[ ]为目标识别算子,04[ ]为目标具体位置求取算子,05[ ]为目标关联、预测、跟踪算子。

观察区域视频获取和观察区域背景估计的目的是为后面的目标区域分割作准备。

(1)目标区域分割:通过目标区域分割获得目标可能的存在区域T(x,y,k)。则有

T(x,y,k)=01[f(x,y,k),…,f(x,y,k-1),…,f(x,y,k-M)]. (1)

(2)目标区域特征描述:对处理得到的可能目标区域T(x,y,k)进行特征描述。例如:02[ ]为几何形状特征提取算子、边缘二值化图像求取算子

S(k)=02[T(x,y,k)], (2)

式中S(k)为识别特征向量。识别特征有许多种,如,统计距特征、几何形状特征等,还可以是归一化的点阵边缘二值图像,在实际系统中,识别特征向量表示为

S(k)=[P(k),Q(k),D(k)], (3)

式中P(k)为目标的重心位置;Q(k)为目标区域T(x,y,k)包围矩形的参数;D(k)是归一化为64×64的边缘二值图像。

(3)目标的确定及模式识别:目标确定是通过对相邻几帧的S(k)分量P(k)和Q(k)进行匹配,从而确认待识目标的过程;目标模式识别算子03[ ]是在识别特征向量空间的运算,其具体的形式取决于具体的识别特征向量S(k),这实际上也是一个特征空间聚类的问题。将03[ ]选为神经元网络识别算子,通过03[ ]对S(k)的分量D(k)识别,判定区域T(x,y,k)是否为目标,该目标为哪一种类型(既车型分类)。

(4)目标具体位置的描述:目标具体位置指假定路面为z=0平面的三维坐标系中,目标的若干特殊点在该坐标系下的具体位置(XT,YT,0),它通过目标具体位置检测算子04[ ]计算得到。在实际系统中04[ ]选为利用针孔模型求取目标区域T(x,y,k)包围矩形的4个端点具体位置的算子(这需要预先进行摄相机标定),则有

(XT,YT,0)=04[Q(k)]. (4)

(5)目标特征空间跟踪:使用05[ ]来对目标的特征进行关联、预测和跟踪,通过以前的目标具体位置数据,对下一帧图像中目标所在位置预测后,利用该具体位置数据和其他特征与下一帧图像中实际目标位置和其他特征进行关联,从而实现空间跟踪。

最后,进行交通信息计算。所计算的交通信息包括:交通流量、空间平均车速、时间平均车速、交通密度、空间占有率、时间占有率、平均车头空距、平均车头时距等。

实践表明:对算子01[ ],02[ ],03[ ],04[ ],05[ ]的具体形式和计算方法的选取是决定视频交通车辆信息检测器性能的关键,其顺序图如图2所示。

1.2 软件主要构架及数学模型

视频交通车辆信息检测器的软件主要构架包括:观察区域视频获取、观察区域背景估计、目标区域分割、目标区域特征描述、目标的确定及模式识别、目标位置的具体描述、目标特征空间跟踪、交通信息计算八部分。

设k(x,y,k)为第K帧序列图像[1],01[ ]为目标区域分割算子,02[ ]为目标识别特征提取算子,03[ ]为目标识别算子,04[ ]为目标具体位置求取算子,05[ ]为目标关联、预测、跟踪算子。

观察区域视频获取和观察区域背景估计的目的是为后面的目标区域分割作准备。

(1)目标区域分割:通过目标区域分割获得目标可能的存在区域T(x,y,k)。则有

T(x,y,k)=01[f(x,y,k),…,f(x,y,k-1),…,f(x,y,k-M)]. (1)

(2)目标区域特征描述:对处理得到的可能目标区域T(x,y,k)进行特征描述。例如:02[ ]为几何形状特征提取算子、边缘二值化图像求取算子

S(k)=02[T(x,y,k)], (2)

式中S(k)为识别特征向量。识别特征有许多种,如,统计距特征、几何形状特征等,还可以是归一化的点阵边缘二值图像,在实际系统中,识别特征向量表示为

S(k)=[P(k),Q(k),D(k)], (3)

式中P(k)为目标的重心位置;Q(k)为目标区域T(x,y,k)包围矩形的参数;D(k)是归一化为64×64的边缘二值图像。

(3)目标的确定及模式识别:目标确定是通过对相邻几帧的S(k)分量P(k)和Q(k)进行匹配,从而确认待识目标的过程;目标模式识别算子03[ ]是在识别特征向量空间的运算,其具体的形式取决于具体的识别特征向量S(k),这实际上也是一个特征空间聚类的问题。将03[ ]选为神经元网络识别算子,通过03[ ]对S(k)的分量D(k)识别,判定区域T(x,y,k)是否为目标,该目标为哪一种类型(既车型分类)。

(4)目标具体位置的描述:目标具体位置指假定路面为z=0平面的三维坐标系中,目标的若干特殊点在该坐标系下的具体位置(XT,YT,0),它通过目标具体位置检测算子04[ ]计算得到。在实际系统中04[ ]选为利用针孔模型求取目标区域T(x,y,k)包围矩形的4个端点具体位置的算子(这需要预先进行摄相机标定),则有

(XT,YT,0)=04[Q(k)]. (4)

(5)目标特征空间跟踪:使用05[ ]来对目标的特征进行关联、预测和跟踪,通过以前的目标具体位置数据,对下一帧图像中目标所在位置预测后,利用该具体位置数据和其他特征与下一帧图像中实际目标位置和其他特征进行关联,从而实现空间跟踪。

最后,进行交通信息计算。所计算的交通信息包括:交通流量、空间平均车速、时间平均车速、交通密度、空间占有率、时间占有率、平均车头空距、平均车头时距等。

实践表明:对算子01[ ],02[ ],03[ ],04[ ],05[ ]的具体形式和计算方法的选取是决定视频交通车辆信息检测器性能的关键,其顺序图如图2所示。

1.3 背景估计与目标的分割、识别

对数字图像中的目标区域进行分割,首先,要进行背景估计。采用长时间边缘图像背景估计方法,即在每单位时段抽取一帧图像,利用柯西边缘算子对此图像进行边缘检测,最后,利用该边缘图像和前面一些时刻所对应的单位时段边缘图像进行背景估计。背景估计公式为

式中i=n-M到n-1;B(x,y,n)为第n时段边缘图像的背景估计;F(x,y,i)为第i时段边缘图像;W(i)为第i时段边缘图像的估计系数。

在实际应用中,取单位时段为30s,M取值为7,W(n)=W(n-1)=5,W(n-2)=W(n-3)=W(n-4)=W(n-5)=4,W(n-6)=W(n-7)=3,Wa=32。

背景估计图像得到后,就可以利用帧差法将当前图像的边缘图与背景估计图像做差,再进行二值化获得边缘帧差二值图。对该边缘帧差二值图再进行膨胀、腐蚀、阴影滤除等一系列计算后,才可以进入目标分割阶段。

采用4连通区域标记方法对连通区域进行检测,从而分割出目标。在进行连通区域检测的过程中,记录下每个目标区域包围矩形的4个端点坐标。对于面积较小的目标区域包围矩形予以删除。既认为是行人等非交通车辆目标干扰。

在目标识别方面,采用了神经元网络识别方法。首先,对预先建立的样本库中的边缘二值图像进行归一化(样本库中不但有机动车辆图像,还有非机动车、行人等图像),归一化后的图像宽高均为64像素,然后,将这些图像以矢量形式送入输入节点为4096个、4层的MLP神经元网络利用BP算法进行训练,该网络只有4个输出节点,即将样本库的归一化边缘二值图像分为四类:小型车、中型车、大型车、拒识。

由于使用上述训练后的神经元网络进行目标识别计算量较大,不可能每帧都对目标区域进行识别,因此,在目标识别前还要进行目标确定的工作。所谓目标确定,指在获得特征向量S(k)分量P(k),Q(k)的基础上,对目标进行简单的二维平面跟踪,通过相邻几帧的P(k),Q(k)欧式距离匹配来确定目标。这种简单的匹配实际上就是利用2个假设:即同一个目标相邻几帧内目标重心变化不大;同一个目标在相邻几帧内目标区域包围矩形的4个端点及区域面积变化不大。如果通过目标分割得到的目标区域在邻近时间内连续多次满足上述2个假设,则认为该目标是可靠的,这样,便可以将该区域确认为待识目标再进行目标识别。识别完成后,若网络不为拒识,则将二维平面目标跟踪链中该目标的可信度属性置为最高级别(置为最高级别可信度的目标将不再进行神经元网络目标识别),同时,车辆计数值加一。

1.4 摄像机标定和目标跟踪

由于所采集的视频图像为二维图像,因此,上述目标分割、确定和目标识别,均为二维运动估计的内容。由于实际应用中摄像机安装固定且水平方向与地面平行,完全可以通过针孔模型摄像机标定方法,以地面为z=0的平面,再利用给定的一组三维空间点坐标和这些点在图像中对应的二维坐标,求解线性方程组,计算透视投影矩阵中的各个元素,从而从二维图像序列中恢复出所跟踪目标的三维信息。这样跟踪目标的一个重要特征,即运动速度也可以很容易计算出来。

本文采用机器视觉中的针孔模型,利用标定后求解得到的透视投影变换矩阵中的参数以及预先测得的摄像机镜头安装的水平倾角和垂直倾角,就可以计算出数字图像中目标包围矩形的4个端点对应以路面为Z=0的三维坐标系中的坐标。这样,就可以检测出交通车辆的实际位置和行驶速度。然后,再利用交通车辆的实际位置和行驶速度等信息进行目标特征空间跟踪。

目标特征空间跟踪采用基于数据关联、点迹预测的跟踪方法。其中,数据关联采用最近邻数据关联法(NNDA)。

数据关联中采用的特征不仅包括目标实际位置和行驶速度这样的信息,还包括数字图像中目标重心、目标面积等二维信息。

点迹预测方面考虑到在实际应用中当噪声统计特性获取不准或目标出现随机时卡尔曼预测器性能会迅速下降,甚至丢失目标,因此,没有采用卡尔曼预测器而采用了比较稳定、计算量小,且易于实现α-β-γ预测器。

另外,定义了目标的6种状态[4],它们是目标产生、目标被正常跟踪、目标合并、目标分裂、目标暂时消失,目标真正消失。其中,目标合并、目标分裂、目标暂时消失是为了解决目标遮挡问题而引入的。

(1)目标合并:当一个被正常跟踪的目标在观察区域内突然丢失,并且,此目标占据的空间被另一较大目标覆盖,则将目标链中此目标的合并分裂属性加一,同时,将此目标置为目标暂时消失状态。下一帧此目标若仍无法检出,则将此目标合并分裂属性继续加一,当此目标合并分裂属性超过一定阀值且其运动速度与较大目标的运动速度相近时,则将此目标与较大目标合并形成一个新的目标,同时,继承原有目标的动态特征,这个新目标被置为目标合并状态。当此目标合并分裂属性没有达到一定阀值时又被检出,则要将此目标从目标暂时消失状态置回目标被正常跟踪状态。

(2)目标分裂:当一个处于目标合并状态的目标突然丢失,并且,此目标占据的空间被一些较小的目标共同占据,则将目标链中此目标的合并分裂属性减一,下一帧此目标若仍无法检出,则将此目标合并分裂属性继续减一,当此目标合并分裂属性低于一定阀值且其运动速度与其分裂出来的那些较小目标的运动速度相近时,则对这些小目标依次建立新的目标链且将它们的状态置为目标产生状态,而较大的前景目标则置为目标真正消失状态,从而便于后续的目标链清理和删除操作。当此目标合并分裂属性没有低于一定阀值时,仍然要将这些较小的目标合并为一个较大的前景目标,并将这个较大的前景目标置为目标分裂状态。

2 实验结果

检测器的某日实际测试数据如表1所示。

由表1可见,白天及夜间环境光较好时,交通流量检测准确率高于90%;车型分类准确率高于85%;某些特殊环境下,检测性能会有所下降,如夜间环境光很弱时,部分车辆漏检;摄像机安装高度不够,且安装角度不陡时,复杂的目标遮挡问题难以通过软件算法克服,在白天强光下,阴影滤处算法效果不明显等。

3 结束语

该视频交通车辆信息检测器实现了对城市交通的整体监控,提高了交通控制和管理水平,合理利用了现有交通设施,充分发挥了其控制违章能力,缓解了道路拥挤状况。同时,由于车辆违章的减少,提高了道路通行能力,减少了油耗从而缓解了城市的车辆尾气污染。